Tài liệu “Machine Learning cơ bản” (MLCB) của tác giả Vũ Hữu Tiệp là một công trình nghiên cứu và biên soạn sâu sắc, phục vụ như một cuốn sách giáo khoa toàn diện về các thuật toán và nguyên lý nền tảng của Học máy (Machine Learning). Cuốn sách được cập nhật lần cuối vào ngày 20 tháng 01 năm 2020 và được xây dựng trên triết lý “Học máy từ gốc”, tập trung vào việc giải thích các công thức toán học, đại số tuyến tính, và xác suất thống kê làm nền tảng cho các mô hình.

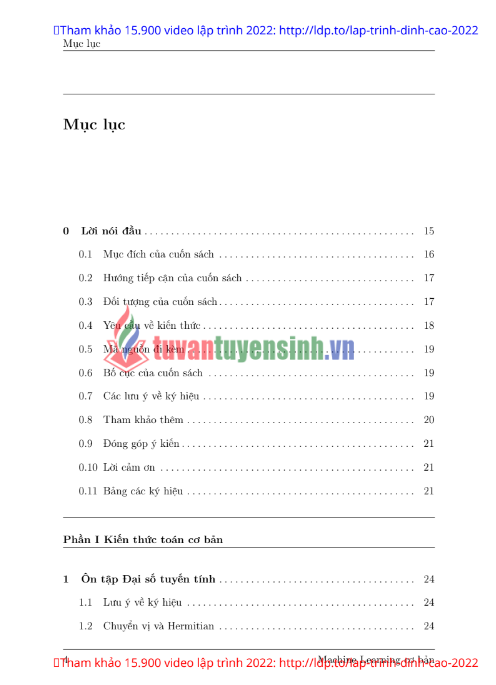

Việc phân tích nội dung cuốn sách đòi hỏi sự tập trung vào các khái niệm chính được đề cập trong phần Mục lục/Chỉ mục (Index), bao gồm các khái niệm từ cơ bản (như vector, ma trận, xác suất) đến các thuật toán phức tạp (như K-Nearest Neighbors, Support Vector Machine, Neural Networks).

1. Tóm Tắt Chi Tiết Nội Dung Tài Liệu Machine Learning Cơ Bản

Dựa trên cấu trúc và Chỉ mục được đề cập, tài liệu MLCB bao gồm một phạm vi kiến thức rộng lớn, được chia thành các khối kiến thức nền tảng và các thuật toán chuyên sâu.

1.1. Nền Tảng Toán Học và Lý Thuyết

Phần đầu của tài liệu chắc chắn tập trung vào việc củng cố các công cụ toán học thiết yếu, là “ngôn ngữ” để mô tả và xây dựng các mô hình Học máy.

1.1.1. Đại số Tuyến tính và Tối ưu hóa

Các khái niệm cốt lõi của Đại số Tuyến tính được giới thiệu, bao gồm:

- Vector và Ma trận: Khái niệm cơ bản về vector hóa (vectorization), vector điểm số (score vector), ma trận trọng số (weight matrix), và vector trọng số (weight vector).

- Thuộc tính Ma trận: Các khái niệm về xác định dương (positive definite) và xác định âm (negative definite), là những thuộc tính quan trọng trong các bài toán tối ưu lồi (convex optimization).

- Tối ưu hóa: Tài liệu đi sâu vào các kỹ thuật tối ưu hóa, đặc biệt là hàm trả về vector (vector-valued function), gradient và tính lồi (convexity). Đây là nền tảng để hiểu cách các mô hình Học máy (ví dụ như Hồi quy tuyến tính, Logistic Regression) tìm ra các tham số tối ưu.

1.1.2. Lý thuyết Xác suất và Thống kê

Tài liệu đề cập đến các khái niệm cơ bản về xác suất, thiết yếu cho các mô hình phân loại dựa trên Xác suất (như Naive Bayes). Các khái niệm bao gồm:

- Xác suất đồng thời (joint probability).

- Xác suất biên (marginal probability/marginalization).

- Xác suất có điều kiện (conditional probability).

- Xác suất hậu nghiệm (posterior probability).

1.2. Các Thuật Toán Học Máy Cổ Điển

Tài liệu cung cấp một cái nhìn chuyên sâu vào các thuật toán Học máy cơ bản đến nâng cao.

1.2.1. Phân loại và Hồi quy

- Hồi quy tuyến tính (Linear Regression): Được sử dụng để dự đoán một giá trị liên tục.

- Hồi quy Logistic (Logistic Regression): Mặc dù tên gọi là “Hồi quy”, đây là một thuật toán phân loại, thường được giải thích thông qua Hàm Sigmoid và tối ưu hóa lồi.

1.2.2. K-Nearest Neighbors (KNN)

Đây là một thuật toán dựa trên khoảng cách (distance-based algorithm) và thuộc nhóm học lười (lazy learning). KNN phân loại một điểm dữ liệu mới bằng cách tìm kiếm $K$ điểm lân cận gần nhất trong tập huấn luyện.

1.2.3. Support Vector Machine (SVM)

Đây là một trong những thuật toán phân loại mạnh mẽ nhất, tập trung vào việc tìm ra siêu phẳng (hyperplane) có khoảng cách lớn nhất đến các điểm dữ liệu gần nhất (support vectors). Các khái niệm liên quan như Dual problem (bài toán đối ngẫu), đối ngẫu yếu (weak duality), và Kernel trick (kỹ thuật hạt nhân) là cốt lõi của thuật toán này.

1.2.4. Phân tích Thành phần Chính (Principal Component Analysis – PCA)

PCA là một kỹ thuật giảm chiều (dimensionality reduction) quan trọng. Tài liệu đề cập đến các khái niệm liên quan như vector riêng (eigenvectors), phương sai nội lớp (within-class variance), và xấp xỉ hạng thấp (low-rank approximation), giúp giảm số lượng đặc trưng mà vẫn giữ được thông tin quan trọng nhất của dữ liệu.

1.3. Học Sâu và Mạng Nơ-ron (Neural Networks)

Tài liệu cũng giới thiệu các khái niệm đầu tiên về Học sâu (Deep Learning), mặc dù đây là “Machine Learning cơ bản”.

- Mạng Nơ-ron: Đề cập đến ma trận trọng số (weight matrix) và vector trọng số (weight vector) trong cấu trúc mạng nơ-ron.

- Weight Decay: Khái niệm về suy giảm trọng số (weight decay) được đề cập thường xuyên trong Chỉ mục, đây là một kỹ thuật chính quy hóa (regularization) quan trọng để ngăn chặn hiện tượng quá khớp (overfitting).

1.4. Các Khái niệm Đặc trưng và Kỹ thuật Liên quan

Cuốn sách còn đề cập đến các vấn đề thực tiễn trong quá trình làm việc với dữ liệu:

- Xử lý Dữ liệu: Khái niệm vector thưa (sparse vector) và vector hoá (vectorization) là cần thiết khi làm việc với dữ liệu có nhiều chiều và phần lớn giá trị là 0 (ví dụ: dữ liệu văn bản).

- Đánh giá Mô hình: Khái niệm xác thực (validation) và leave-one-out là các kỹ thuật đánh giá sự tổng quát hóa của mô hình trên dữ liệu chưa thấy.

2. Cảm Nhận Cá Nhân Về Tài Liệu “Machine Learning Cơ Bản”

Cảm nhận chung về tài liệu “Machine Learning cơ bản” là đây không chỉ là một tài liệu học thuật đơn thuần mà còn là một công trình mang tính định hướng, giúp người học chuyển từ việc sử dụng thư viện (library usage) sang việc thực sự hiểu các nguyên lý hoạt động của thuật toán. Sự tập trung vào các khái niệm toán học nền tảng là điểm mạnh nổi trội và cũng là thử thách lớn nhất của cuốn sách.

2.1. Cấu Trúc và Triết Lý Biên Soạn: Học Từ Gốc

Triết lý “Học máy từ gốc” (Machine Learning from scratch) được thể hiện rõ ràng qua sự ưu tiên cho các chương nền tảng. Thay vì nhảy thẳng vào các thuật toán, tài liệu dành một lượng lớn nội dung để xây dựng lại kiến thức về Đại số Tuyến tính, Tối ưu hóa, và Xác suất.

2.1.1. Tầm quan trọng của Nền tảng Toán học

Việc đưa các khái niệm toán học phức tạp như xác định dương/âm (positive/negative definite) hay hàm trả về vector (vector-valued function) vào đầu sách là một quyết định dũng cảm nhưng chính xác. Trong Học máy hiện đại, người làm việc phải đối mặt với các vấn đề tối ưu lồi (convex optimization) và các ma trận hiệp phương sai. Nếu không hiểu rõ về thuộc tính của ma trận và các khái niệm như gradient (đạo hàm vector), người học sẽ không thể thực sự tinh chỉnh (tweak) các thuật toán hoặc xây dựng mô hình tùy chỉnh.

Cá nhân tôi cảm nhận rằng, cách tiếp cận này giúp tạo ra một thế hệ Kỹ sư Học máy không chỉ biết gọi hàm fit(), mà còn hiểu được tại sao mô hình lại hội tụ (converge) hay tại sao lại xảy ra hiện tượng quá khớp (overfitting). Đây là sự khác biệt giữa một người dùng công cụ và một người tạo ra công cụ.

2.1.2. Ưu điểm của Tính Minh bạch và Logic

Khi một thuật toán như SVM được giới thiệu, việc đi sâu vào bài toán đối ngẫu (Dual problem) và đối ngẫu yếu (weak duality) thay vì chỉ trình bày công thức cuối cùng cho thấy sự cam kết của tác giả đối với tính minh bạch logic. Trong Học máy, bài toán tối ưu luôn có hai mặt: bài toán gốc (Primal) và bài toán đối ngẫu (Dual). Hiểu được mối quan hệ này không chỉ là kiến thức hàn lâm mà còn là yếu tố quan trọng để lựa chọn thuật toán giải quyết (solver) hiệu quả.

2.2. Cảm Nhận Về Độ Sâu của Các Thuật Toán Cốt Lõi

Tài liệu đã chọn lọc các thuật toán cốt lõi một cách hợp lý, bao gồm các đại diện tiêu biểu từ các nhóm: Hồi quy, Phân loại, và Giảm chiều.

2.2.1. Sự Kết nối giữa Toán và Mô hình

Trong phần Hồi quy và Phân loại, mối liên hệ giữa vector trọng số (weight vector) và tối ưu hóa phải là trọng tâm. Ví dụ, Hồi quy Tuyến tính là mô hình đơn giản nhất nhưng là cơ sở để hiểu về hàm mất mát (loss function) và cách tìm điểm cực tiểu bằng phương pháp Gradient Descent.

Việc giới thiệu sớm về suy giảm trọng số (weight decay) là một điểm mạnh lớn. Suy giảm trọng số, hay L2 Regularization, là một kỹ thuật thiết yếu để kiểm soát sự phức tạp của mô hình và tránh quá khớp. Việc đề cập đến nó trong nhiều bối cảnh khác nhau (trang 115, 190, 208, 392) nhấn mạnh tầm quan trọng của nó trong việc xây dựng mô hình tổng quát hóa tốt.

2.2.2. Phân tích Thành phần Chính (PCA) – Khai thác Dữ liệu Đa chiều

Việc đưa PCA vào tài liệu cơ bản là cần thiết. Trong thế giới Big Data, việc đối phó với dữ liệu có hàng trăm, thậm chí hàng nghìn đặc trưng là phổ biến. PCA, với sự liên quan đến vector riêng (eigenvectors) và xấp xỉ hạng thấp (low-rank approximation), không chỉ là một công cụ giảm chiều mà còn là một phương pháp quan trọng để trực quan hóa dữ liệu và loại bỏ nhiễu.

Cảm nhận của tôi là PCA không chỉ là giảm chiều dữ liệu mà còn là việc tìm ra các phương sai (variance) quan trọng nhất của dữ liệu, từ đó giúp người học hiểu bản chất của dữ liệu đang làm việc. Các khái niệm như phương sai nội lớp (within-class variance) cũng ngầm chỉ ra sự chuẩn bị cho các thuật toán phân biệt (discriminant analysis) phức tạp hơn sau này.

2.3. Tính Thực tiễn và Ứng dụng: Xử lý Dữ liệu Thực tế

Tài liệu không bỏ qua các vấn đề phát sinh trong thực tế triển khai Học máy.

2.3.1. Vector Hóa và Vector Thưa

Việc đề cập đến vector hóa (vectorization) và vector thưa (sparse vector) là rất thực tế. Trong Lập trình Học máy, việc chuyển các phép toán vòng lặp Python chậm chạp sang các phép toán ma trận nhanh hơn (vectorization) là chìa khóa để đạt hiệu suất cao.

Đặc biệt, vector thưa (sparse vector) rất quan trọng trong Xử lý Ngôn ngữ Tự nhiên (NLP) hoặc hệ thống khuyến nghị (Recommendation Systems), nơi dữ liệu thường chứa rất nhiều số không. Việc biết cách lưu trữ và thao tác với dữ liệu thưa là kỹ năng bắt buộc để tiết kiệm bộ nhớ và tăng tốc độ tính toán, một yếu tố thường bị bỏ qua trong các giáo trình lý thuyết.

2.3.2. Đánh giá Mô hình và Xác thực

Khái niệm xác thực (validation) và leave-one-out (một kỹ thuật cross-validation) là cực kỳ quan trọng. Trong Học máy, việc đánh giá mô hình không chỉ dừng lại ở độ chính xác trên tập huấn luyện. Sự tổng quát hóa (generalization) của mô hình trên dữ liệu mới là mục tiêu cuối cùng. Việc giới thiệu các kỹ thuật xác thực ngay từ đầu giúp người học tránh được cạm bẫy của việc đánh giá sai lệch, đặc biệt là hiện tượng quá khớp (overfitting).

2.4. Kết Luận và Lời Khuyên Cho Người Học

Tài liệu “Machine Learning cơ bản” là một nguồn tài nguyên quý giá cho những ai nghiêm túc muốn theo đuổi lĩnh vực Học máy. Tuy nhiên, với độ sâu về toán học và lý thuyết, đây không phải là một cuốn sách dễ đọc cho người mới bắt đầu không có nền tảng toán vững chắc.

2.4.1. Điểm Mạnh Nổi Bật

- Tính toàn diện về Lý thuyết: Tài liệu cung cấp giải thích chi tiết và toàn diện về các thuật toán từ góc độ toán học (Đại số, Xác suất, Tối ưu hóa).

- Tính Thực dụng: Việc đề cập đến các kỹ thuật như weight decay, vectorization, và xử lý vector thưa cho thấy tài liệu được xây dựng bởi người có kinh nghiệm thực chiến.

- Khuyến khích Tư duy Phân tích: Cuốn sách thách thức người học phải suy nghĩ về “tại sao” một thuật toán hoạt động, thay vì chỉ “cách” sử dụng nó.

2.4.2. Khuyến nghị và Triển vọng Ứng dụng

Để tận dụng tối đa cuốn sách này, người học nên:

- Kết hợp Lý thuyết với Thực hành: Mỗi chương nên được đi kèm với việc tự viết mã nguồn (code from scratch) cho thuật toán đó (ví dụ: tự xây dựng hàm

Gradient Descentthay vì dùng thư viện). - Củng cố Nền tảng Toán học: Song song với việc đọc sách, cần ôn tập sâu các kiến thức về Đại số Tuyến tính (phép nhân ma trận, định thức, vector riêng) và Giải tích (đạo hàm riêng, đạo hàm chuỗi).

Tóm lại, “Machine Learning cơ bản” là một tài liệu chuẩn mực và có giá trị bền vững. Nó trang bị cho người học không chỉ kiến thức mà còn cả tư duy nền tảng cần thiết để theo kịp tốc độ phát triển chóng mặt của lĩnh vực Khoa học Dữ liệu và Học sâu. Bất kỳ ai muốn trở thành một nhà khoa học dữ liệu hoặc kỹ sư Học máy thực thụ đều cần phải làm chủ được các nguyên lý toán học sâu sắc được trình bày trong tài liệu này.