Báo Cáo Tóm Tắt Chi Tiết và Cảm Nhận Chuyên Sâu về Bài Giảng “HỌC MÁY”

Tài liệu “BÀI GIẢNG HỌC MÁY” được biên soạn bởi Đàm Thanh Phương, Hà Thị Thanh, và Trần Quang Quý thuộc Trường Đại Học CNTT&TT, Khoa Công Nghệ Thông Tin. Bài giảng này cung cấp một cái nhìn toàn diện và chuyên sâu về lĩnh vực Học máy (Machine Learning), bao gồm cả các thuật toán cơ bản, các kỹ thuật tối ưu hàm mất mát, phân tích toán học, và các ứng dụng thực tiễn qua mã nguồn Python. Với cấu trúc gồm 4 Chương và 15 chủ đề chính, giáo trình này là một nền tảng vững chắc cho sinh viên và nhà nghiên cứu muốn nắm bắt các kiến thức cốt lõi của Học máy.

Bài báo cáo này sẽ tiến hành tóm tắt hệ thống các chủ đề được trình bày trong giáo trình và đưa ra cảm nhận cá nhân về tính học thuật, tính ứng dụng, và giá trị chiến lược của tài liệu này trong bối cảnh phát triển của Trí tuệ Nhân tạo (AI).

1. Tóm Tắt Hệ Thống Kiến Thức Cốt Lõi

Giáo trình được tổ chức một cách logic, bắt đầu bằng các khái niệm tổng quan và thuật ngữ chuyên ngành , sau đó đi sâu vào các nhóm thuật toán chính (Học có giám sát, Học không giám sát) và kết thúc bằng một ứng dụng quan trọng trong thực tế (Hệ thống Gợi ý).

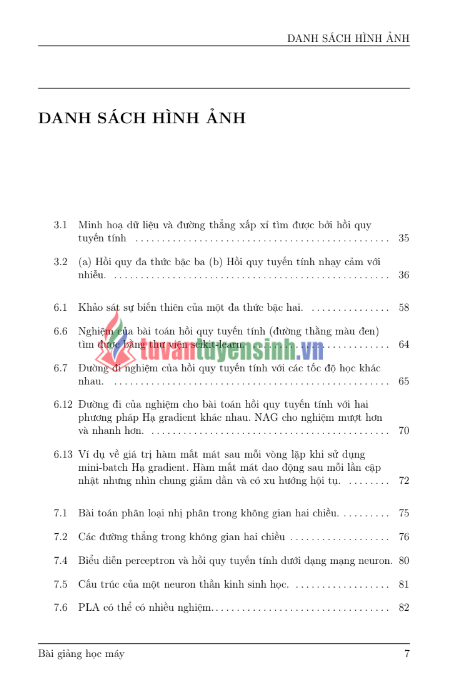

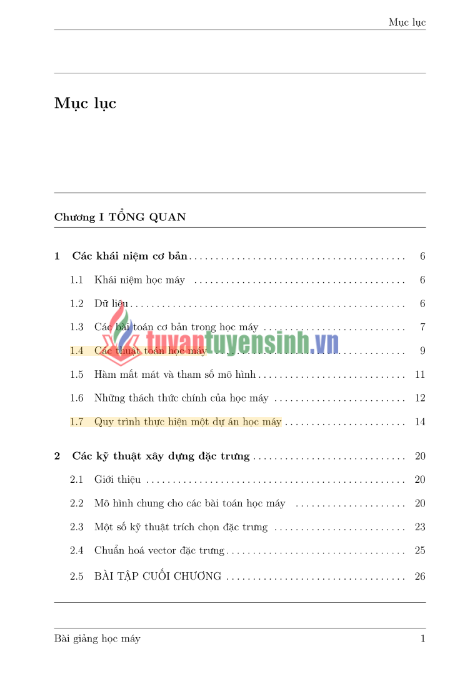

1. Chương I: Tổng Quan và Chuẩn Bị Dữ Liệu

Chương này thiết lập nền tảng lý thuyết và quy trình làm việc cần thiết trước khi đi vào các thuật toán cụ thể.

- Các khái niệm cơ bản:

- Khái niệm học máy: Học máy là lĩnh vực nghiên cứu nhằm giúp máy tính có khả năng học mà không cần lập trình một cách tường minh. Định nghĩa cơ bản yêu cầu một chương trình “học tập” từ kinh nghiệm E (dữ liệu huấn luyện) để hoàn thành nhiệm vụ T với hiệu quả được đo bằng phép đánh giá P.

- Dữ liệu: Dữ liệu đầu vào, như ảnh, âm thanh, hay văn bản, thường được chuyển về dạng vector đặc trưng hoặc ma trận (tensor) để máy tính xử lý. Bộ dữ liệu được chia thành Tập huấn luyện (training set) để xây dựng mô hình, Tập kiểm tra (test set) để đánh giá tính phổ quát, và Tập xác thực (validation set) để lựa chọn các siêu tham số mô hình.

- Các bài toán cơ bản: Bao gồm Phân lớp (Classification) – xác định nhãn C cho điểm dữ liệu , và Hồi quy (Regression) – dự đoán giá trị liên tục. Ngoài ra còn có các bài toán khác như Phân cụm, Giảm chiều dữ liệu, và Phát hiện bất thường.

- Các thuật toán học máy: Phân loại theo phương thức học thành Học có giám sát (dựa trên cặp (đầu vào, đầu ra) đã biết), Học không giám sát (tìm cấu trúc ẩn trong dữ liệu không nhãn), Học bán giám sát, và Học tăng cường.

- Hàm mất mát và tham số mô hình: Công việc của thuật toán là đi tìm bộ tham số mô hình tối ưu, làm giảm giá trị của Hàm mất mát (Loss function). Tối thiểu hàm mất mát tương đương với việc phép đánh giá cho kết quả tốt (sai số nhỏ nhất).

- Những thách thức chính: Gồm Thiếu dữ liệu huấn luyện, Chất lượng dữ liệu kém (dữ liệu nhiễu, không đầy đủ, ngoại lai) , Mô hình kém hiệu quả trên tập huấn luyện (Underfitting) và Mô hình quá khớp (Overfitting). Giáo trình cũng đề xuất các giải pháp như thu thập thêm dữ liệu, làm sạch dữ liệu, chọn mô hình mạnh hơn, hoặc giảm ràng buộc lên mô hình.

- Quy trình thực hiện dự án: Danh mục các công việc bao gồm 8 bước: Định hình bài toán, Thu thập dữ liệu, Khám phá dữ liệu, Chuẩn bị dữ liệu, Khám phá các mô hình, Tinh chỉnh các mô hình, Trình bày giải pháp, và Triển khai.

- Các kỹ thuật xây dựng đặc trưng:

- Đặc trưng (Feature) là vector đại diện cho điểm dữ liệu. Việc xây dựng đặc trưng quan trọng vì dữ liệu thô có thể có kích thước khác nhau hoặc quá lớn.

- Các kỹ thuật bao gồm Trích chọn đặc trưng (Feature Extraction) và Chuẩn hoá vector đặc trưng (Feature Scaling), như chuẩn hoá về độ dài bằng 1.

2. Chương II: Các Thuật Toán Học Có Giám Sát

Chương này bao gồm 8 thuật toán cơ bản và nâng cao, trọng tâm là Hồi quy và Phân loại.

- Hồi quy tuyến tính (Linear Regression):

- Là thuật toán cơ bản nhất, dùng để dự đoán một giá trị liên tục bằng cách tìm một đường thẳng/mặt phẳng xấp xỉ dữ liệu.

- Tập trung vào việc Xây dựng và tối ưu hàm mất mát (Loss Function), thường là bình phương khoảng cách (Mean Squared Error).

- K lân cận (K-Nearest Neighbors – KNN):

- Là một thuật toán phân loại dựa trên việc gán nhãn cho một điểm dữ liệu mới dựa trên nhãn của K điểm dữ liệu gần nhất trong tập huấn luyện.

- Giáo trình cung cấp Phân tích toán học và ví dụ trên cơ sở dữ liệu Iris.

- Bộ phân loại naive Bayes (Naive Bayes Classifier – NBC):

- Là một thuật toán phân loại dựa trên Định lý Bayes, với giả định đơn giản là các đặc trưng là độc lập với nhau (naive assumption).

- Trình bày các phân phối thường dùng (Gaussian, Multinomial) trong NBC.

- Hạ Gradient (Gradient Descent – GD):

- Đây là một trong những thuật toán tối ưu quan trọng nhất trong Học máy và Học sâu.

- Mục tiêu là tìm cực tiểu của hàm mất mát bằng cách di chuyển ngược hướng với gradient (độ dốc).

- Giới thiệu các biến thể hiện đại như Hạ gradient với momentum, Nesterov accelerated gradient, và Hạ gradient ngẫu nhiên (Stochastic Gradient Descent).

- Thuật toán học perceptron (Perceptron Learning Algorithm – PLA):

- Là mô hình mạng neuron đơn giản đầu tiên, dùng để phân loại nhị phân.

- Giáo trình minh họa PLA như là mô hình mạng neuron đầu tiên và so sánh với hồi quy tuyến tính.

- Hồi quy logistic (Logistic Regression):

- Mặc dù có tên là “Hồi quy”, đây thực chất là một thuật toán phân loại nhị phân.

- Sử dụng Hàm sigmoid để ánh xạ đầu ra thành xác suất.

- Mở rộng sang Bài toán phân loại đa lớp bằng cách sử dụng nhiều bộ phân loại nhị phân.

- Hồi quy softmax (Softmax Regression):

- Là sự tổng quát hóa của Hồi quy Logistic cho bài toán phân loại đa lớp trực tiếp.

- Sử dụng Hàm softmax để tạo ra phân phối xác suất trên nhiều lớp.

- Máy vector hỗ trợ (Support Vector Machine – SVM):

- Là thuật toán phân loại tìm ra mặt phân chia (hyperplane) có lề (margin) lớn nhất giữa các lớp.

- Trình bày chi tiết cách Xây dựng bài toán tối ưu (tối thiểu hóa) và chuyển sang Bài toán đối ngẫu để giải quyết.

3. Chương III: Các Thuật Toán Học Không Giám Sát

Chương này tập trung vào các kỹ thuật khai phá cấu trúc ẩn của dữ liệu không nhãn.

- Phân cụm K-means:

- Là thuật toán phân cụm phổ biến nhất, dùng để chia dữ liệu thành K cụm, sao cho các điểm trong cùng một cụm có khoảng cách tới tâm cụm là nhỏ nhất.

- Trình bày Phân tích toán học và các ứng dụng thực tế: Phân cụm chữ số viết tay, Tách vật thể trong ảnh, và Nén ảnh.

- Phân tích thành phần chính (Principal Component Analysis – PCA):

- Là kỹ thuật giảm chiều dữ liệu bằng cách chiếu dữ liệu lên một không gian mới có số chiều nhỏ hơn, giữ lại được nhiều phương sai (thông tin) nhất.

- Phân tích Liên hệ với phân tích giá trị suy biến (SVD).

- Giới thiệu các ứng dụng như tái tạo ảnh khuôn mặt và dò tìm điểm bất thường.

4. Chương IV: Hệ Thống Gợi Ý

Chương cuối cùng đi vào một ứng dụng thực tiễn rất quan trọng của Học máy.

- Hệ thống gợi ý dựa trên nội dung (Content-Based Filtering):

- Xây dựng mô hình để gợi ý sản phẩm/nội dung cho người dùng dựa trên hồ sơ sở thích của chính người dùng đó.

- Giới thiệu khái niệm Ma trận tiện ích (Utility Matrix) và áp dụng vào Bài toán MovieLens 100k.

- Lọc cộng tác lân cận (Nearest Neighbor Collaborative Filtering):

- Gợi ý dựa trên sự tương đồng giữa người dùng (User-based CF) hoặc sự tương đồng giữa sản phẩm (Item-based CF).

- Lọc cộng tác phân tích ma trận (Matrix Factorization Collaborative Filtering):

- Sử dụng kỹ thuật phân rã ma trận tiện ích thành hai ma trận thấp chiều hơn, đại diện cho các đặc trưng ẩn của người dùng và sản phẩm.

- Trình bày cách Xây dựng và tối ưu hàm mất mát cho mô hình này.

2. Cảm Nhận Cá Nhân và Đánh Giá Sâu Sắc về Giáo Trình

Giáo trình “HỌC MÁY” này là một tài liệu học thuật xuất sắc, được xây dựng với sự cân bằng hoàn hảo giữa lý thuyết toán học chuyên sâu và tính ứng dụng thực tiễn thông qua các ví dụ lập trình Python.

1. Tính Chuyên Sâu và Sự Cân Bằng Học Thuật

Cảm nhận đầu tiên là sự nghiêm túc và chuyên nghiệp trong cách tiếp cận các chủ đề.

- Độ Phủ Kiến Thức Toàn Diện:

- Giáo trình đã bao quát một cách có hệ thống tất cả các trụ cột của Học máy: Học có giám sát (Hồi quy, Phân loại: KNN, Naive Bayes, Logistic, SVM) , Học không giám sát (K-means, PCA) , và một lĩnh vực ứng dụng quan trọng là Hệ thống Gợi ý. Độ phủ này đảm bảo người học nắm được bức tranh tổng thể về các loại bài toán Học máy khác nhau.

- Sự Nhấn Mạnh vào Nền Tảng Toán Học:

- Điểm mạnh vượt trội là việc không né tránh các phân tích toán học. Ví dụ, việc trình bày chi tiết về Phân tích toán học cho thuật toán K lân cận và Phân cụm K-means , hay việc đi sâu vào Bài toán đối ngẫu của Máy vector hỗ trợ (SVM) là cực kỳ quan trọng. Điều này giúp người học không chỉ biết cách sử dụng thư viện mà còn hiểu được cơ chế hoạt động, từ đó có thể tự điều chỉnh và thiết kế thuật toán mới.

- Chiến Lược Tối Ưu Hóa Hàm Mất Mát:

- Việc dành riêng một chủ đề lớn cho các kỹ thuật Hạ Gradient (GD) là một quyết định chiến lược. GD là trái tim của hầu hết các thuật toán Học sâu (Deep Learning). Việc giới thiệu các biến thể nâng cao như Momentum và Nesterov ngay trong giáo trình cơ bản tạo ra một sự chuẩn bị xuất sắc cho những ai muốn tiếp tục học về Mạng Neuron. Nó giúp người học nhận ra tầm quan trọng của việc tối ưu hóa trong Học máy.

2. Định Hướng Ứng Dụng và Quy Trình Thực Tiễn

Giáo trình không chỉ là lý thuyết mà còn là một cẩm nang hướng dẫn thực hành.

- Kết Nối Lý Thuyết với Python:

- Hầu hết các chủ đề quan trọng đều có phần Ví dụ trên Python hoặc Triển khai thuật toán trên Python (Hồi quy tuyến tính, KNN, Logistic, Softmax, K-means, Lọc cộng tác). Điều này đảm bảo tính thực tiễn cao, giúp người học chuyển kiến thức hàn lâm thành kỹ năng lập trình chuyên nghiệp. Python là ngôn ngữ tiêu chuẩn của Học máy, và việc tích hợp sớm các ví dụ lập trình là thiết yếu.

- Quy Trình Dự Án Chuẩn Mực:

- Phần Quy trình thực hiện một dự án học máy trong Chương I là một hướng dẫn thực tế vô giá. Danh mục 8 bước, từ Định hình bài toán đến Triển khai, phản ánh đúng chuẩn mực công nghiệp, vượt ra khỏi giới hạn của một bài giảng lý thuyết đơn thuần. Nó định hình tư duy của người học về vai trò của một Kỹ sư Học máy (Machine Learning Engineer), người không chỉ viết code mà còn quản lý dự án, xử lý dữ liệu và truyền đạt giải pháp.

- Sự Tinh Tế trong Xử Lý Dữ Liệu:

- Việc dành riêng một bài cho Các kỹ thuật xây dựng đặc trưng và bàn luận về các thách thức dữ liệu (thiếu, nhiễu, ngoại lai) cho thấy sự hiểu biết sâu sắc về thực tiễn. Trong Học máy, 80% công việc là về dữ liệu (Feature Engineering, Data Cleaning), và giáo trình đã đúng đắn khi đưa các kỹ thuật này lên vị trí đầu tiên. Việc giới thiệu các phương pháp chuẩn hoá vector về độ dài 1 là một chi tiết kỹ thuật cần thiết trong nhiều ứng dụng thực tế.

3. Giá Trị Chiến Lược và Tầm Nhìn Tương Lai

Giáo trình này không chỉ dạy kiến thức mà còn mở ra tầm nhìn chiến lược về các lĩnh vực ứng dụng.

- Lĩnh vực Hệ thống Gợi ý:

- Việc dành hẳn Chương IV cho Hệ thống Gợi ý là một quyết định thông minh. Hệ thống gợi ý là xương sống của các nền tảng thương mại điện tử (Amazon) và giải trí (Netflix, TikTok) hiện đại.

- Sự phân tích từ Gợi ý dựa trên nội dung đến Lọc cộng tác (lân cận và phân tích ma trận) cho thấy một sự tiếp cận toàn diện, cung cấp cho người học các mô hình khác nhau để giải quyết bài toán cốt lõi này. Phân tích ma trận, đặc biệt, là một kỹ thuật mạnh mẽ, hiện đại, và cần thiết cho việc xây dựng các hệ thống gợi ý quy mô lớn.

- Nền tảng cho Học sâu (Deep Learning):

- Các chủ đề như Hạ Gradient , Hồi quy Softmax , và Thuật toán Perceptron là những viên gạch cơ bản xây dựng nên Mạng Neuron và Học sâu. Việc nắm vững các khái niệm này sẽ giúp người học dễ dàng chuyển tiếp sang các mô hình phức tạp hơn như Mạng Neuron Tích chập (CNN) hay Mạng Neuron Hồi quy (RNN) sau này. Đặc biệt, việc minh họa Perceptron như là mô hình mạng neuron đầu tiên là cách tiếp cận sư phạm hiệu quả để giới thiệu về Học sâu.

- Khắc Phục Thách Thức Học máy:

- Việc dành một phần lớn để trình bày các thách thức như Overfitting và Underfitting cùng các phương pháp giải quyết là cực kỳ hữu ích. Điều này giúp người học phát triển kỹ năng đánh giá và tinh chỉnh mô hình ngay từ đầu, tránh việc chỉ biết áp dụng thuật toán một cách máy móc.

4. Kết Luận Chung

Giáo trình “BÀI GIẢNG HỌC MÁY” này là một tài liệu học tập toàn diện, chuyên sâu, và mang tính định hướng cao, rất phù hợp cho sinh viên Công nghệ Thông tin.

- Cấu trúc Logic và Tính Ứng Dụng: Giáo trình đi từ tổng quan (khái niệm, quy trình, dữ liệu) đến chi tiết (thuật toán có giám sát, không giám sát) và kết thúc bằng một ứng dụng thực tiễn lớn (hệ thống gợi ý).

- Sự Kết Hợp Hoàn Hảo: Sự kết hợp giữa toán học (phân tích hàm mất mát, đối ngẫu SVM) và lập trình (ví dụ Python) tạo ra một nguồn tài liệu cân bằng, giúp người học phát triển cả tư duy nghiên cứu và kỹ năng triển khai.

- Tầm nhìn Tương Lai: Tài liệu cung cấp nền tảng vững chắc để tiếp tục khám phá các lĩnh vực tiên tiến hơn của AI như Học sâu, Xử lý ngôn ngữ tự nhiên, hay Thị giác máy tính, đặt người học vào vị trí thuận lợi để tham gia vào cuộc cách mạng công nghiệp 4.0.

Với hơn 15 chủ đề chuyên sâu được phân tích, cùng với sự nhấn mạnh vào nền tảng toán học, kỹ thuật tối ưu hóa, và các ứng dụng thực tiễn, giáo trình này thực sự là “bộ khung” kiến thức không thể thiếu cho bất kỳ ai muốn làm chủ lĩnh vực Học máy.